Sei un consulente SEO e vuoi scoprire come ottimizzare al meglio il tuo file robots.txt? Oppure sei un profano della SEO e hai necessità di esplorare il mondo del web marketing per capire come gestire il tuo sito in maniera efficace? Qualsiasi sia il tuo obiettivo, questo articolo di approfondimento ti aiuterà a comprendere innanzitutto cos’è un file robots.txt e, poi, come ottimizzarlo ai fini SEO.

Partiamo quindi dalle basi. Il file robots.txt è associato ad un sito (o ad un sottodominio) a livello globale, quindi non a livello di singola pagina e viene utilizzato dai SEO specialist e dai webmaster per fornire istruzioni ai motori di ricerca e più nello specifico ai bot che gestiscono la scansione del web.

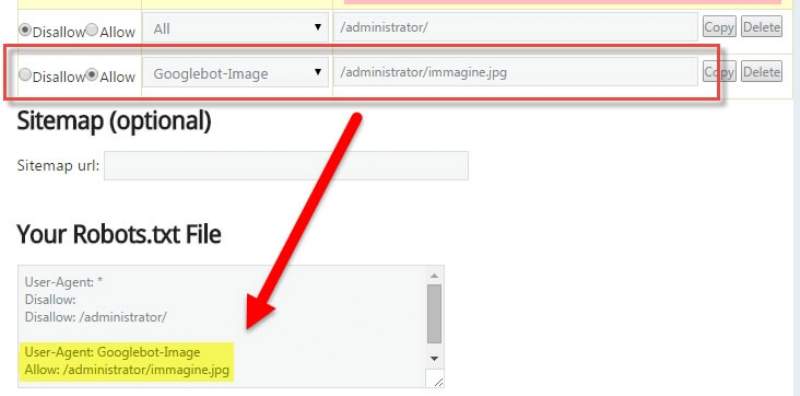

Quando un bot scansiona un sito, infatti, dovrà seguire le istruzioni presenti nel file robots.txt. Il quale potrà per esempio indicare al motore di ricerca di non scansionare una o più pagine del sito. Nel caso di WordPress, per fare un esempio concreto, la stringa “Disallow: /wp-admin/” indica al bot del motore di ricerca di non scansionare ed indicizzare dunque, la cartella indicata.

La prima riga del file robots.txt è generalmente:

User-agent: *

Si tratta di un comando che specifica quali sono i bot destinatari delle istruzioni che seguono. In questo caso, * indica tutti i bot. La riga successiva potrebbe essere:

Disallow:

In questo caso l’intero sito verrà sottoposto a scansione da parte di tutti i bot, senza alcuna eccezione.

Da questo punto di vista, poiché è bene bloccare l’indicizzazione di tutte le pagine e i contenuti relativi al back office, un buon file robots.txt potrebbe contenere le seguenti istruzioni (nel caso di utilizzo di CMS WordPress):

Disallow: /wp-

Disallow: /cgi-bin/

Disallow: /wp-admin/

Disallow: /wp-includes/

Disallow: /wp-content/

Allow: /wp-content/uploads

L’ultima riga indica ai bot che potranno avere accesso, e quindi indicizzare nel motore di ricerca, alla cartella uploads, che contiene, in questo esempio, immagini e altri file multimediali.

Per evitare, inoltre, l’indicizzazione di duplicati (in particolare commenti, feedback, tag e categorie) è possibile utilizzare le seguenti stringhe:

Disallow: /trackback/

Disallow: /feed/

Disallow: /comments/

Disallow: */trackback/

Disallow: */feed/

Disallow: */comments/

L’indicizzazione di tag e categorie, come sappiamo, potrebbe generare duplicazioni e quindi portare a penalizzazioni (la cosiddetta penalizzazione da ‘tag excess’, che colpisce siti che fanno uso di centinaia o migliaia di tag in modo indiscriminato). In questo caso si potrebbe pensare di bloccarne l’indicizzazione da file robots.txt ma è possibile, in modo più semplice ed elegante, agire a livello di plugin SEO. Chi utilizza il plugin SEO by Yoast, infatti, sa bene che tramite la funzionalità di indicizzazione è possibile specificare quali contenuti far indicizzare e quali no.

L’ultima riga del file robot.txt dovrà contenere un riferimento alla sitemap, o mappa dei contenuti, che fornisce al motore di ricerca una panoramica delle pagine che compongono il sito web.

Tramite la riga:

Sitemap: http://ilmiosito.it/sitemap.xml

è possibile indicare ai motori di ricerca dove si trova la mappa del sito, che contiene un elenco esaustivo di tutti i contenuti da indicizzare. Sempre facendo ricorso al plugin SEO by Yoast è possibile specificare quali pagine non dovranno essere inserita nella sitemap.